#include <NewtonModified.h>

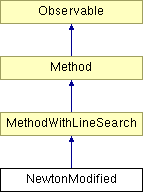

Diagram dziedziczenia dla NewtonModified

Przy wykorzystaniu do minimalizacji funkcji niekwadratowych metoda Newtona nie jest niezawodna. Gdy punkt startowy znajduje się daleko od minimum, krok metody może okazać się zbyt duży, co z kolei może doprowadzić do niezbieżności metody. Najprostszą modyfikacją metody Newtona jest wprowadzenie etapu poszukiwania optymalnej długości kroku w kierunku  , podobnie jak w metodzie Cauchy'ego (największego spadku). Zapewnia to zmniejszanie się wartości funkcji w punkcie roboczym z kroku na krok.

, podobnie jak w metodzie Cauchy'ego (największego spadku). Zapewnia to zmniejszanie się wartości funkcji w punkcie roboczym z kroku na krok.

Algorytm metody:

Oznaczenia:

- numer aktualnej iteracji

- numer aktualnej iteracji

- gradient w punkcie

- gradient w punkcie

- macierz hesjanu w punkcie

- macierz hesjanu w punkcie

- współczynnik długości kroku

- współczynnik długości kroku

Dane potrzebne do obliczeń:

- minimalizowana funkcja celu

- minimalizowana funkcja celu

- punkt startowy

- punkt startowy

- wymagana dokładność

- wymagana dokładność

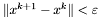

warunek stopu - do wyboru:

,

,  ,

,  ,

,  .

. jako wynik. W przeciwnym wypadku przejdź do kroku 2.

jako wynik. W przeciwnym wypadku przejdź do kroku 2.

![\[ | \nabla^2 f(x^k)) | = 0 \]](form_318.png)

Jeśli tak to STOP: Hesjan jest macierzą osobliwą.

W przeciwnym wypadku przejdź do kroku 3.

Krok 3:

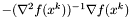

Wyznacz kierunek poszukiwań  :

:

![\[ d = -(\nabla^2 f(x^k))^{-1} \nabla f(x^k). \]](form_321.png)

Wykonaj krok w kierunku  o optymalnej długości

o optymalnej długości  :

:

![\[ \tau = \arg \min_{\tau} f(x^k + \tau d), \]](form_322.png)

![\[ x^{k+1} = x^k + \tau d. \]](form_323.png)

Podstaw  i przejdź do kroku 1.

i przejdź do kroku 1.

Uwagi:

W stosunku do wersji algorytmu zamieszczonej w [1] zmieniono kolejność wykonywania kroków. W zaimplementowanej wersji sprawdzanie warunku stopu dokonuje się na początku każdej iteracji. Dzięki temu algorytm może zatrzymać się nie wykonując żadnej iteracji w przypadku gdy punkt startowy znajduje sie w minimum i wykorzystywany jest "gradientowy" warunek stopu. Początkowe wartości zmiennych oznaczających rożnice położenia dwóch ostatnich punktów oraz różnice wartości funkcji w tych dwóch punktach są równe DBL_MAX, więc w przypadku wykorzystaniu innego warunku stopu niż "gradientowy" modyfikacja nie będzie miała żadnego wpływu na działanie algorytmu.

Algorytm zaimplementowano na podstawie:

Ostanin. A: Metody i algorytmy optymalizacji, Wydawnictwo Politechniki Białostockiej, Białystok, 2003